Sztuczna inteligencja jak broń jądrowa

Podczas rozmowy w programie "60 Minutes" w amerykańskiej stacji CBS Pichai wezwał do stworzenia globalnych ram regulacyjnych dla sztucznej inteligencji (AI), podobnych do traktatów zawartych w sprawie broni jądrowej, ponieważ - jak ostrzegł - rywalizacja o wyprodukowanie bardziej zaawansowanej technologii może prowadzić do odsuwania na bok obaw związanych z bezpieczeństwem.

"Może być bardzo szkodliwa, jeśli zostanie źle wdrożona i nie mamy jeszcze wszystkich odpowiedzi - a technologia porusza się szybko. Więc czy to nie pozwala mi spać w nocy? Absolutnie" - powiedział.

Będący właścicielem Google'a, konglomerat Alphabet Inc. w marcu uruchomił chatbota Bard, odpowiadając na globalną popularność ChatGPT, opracowanego przez amerykańską firmę technologiczną OpenAI, który został zaprezentowany w listopadzie zeszłego roku.

Pichai powiedział, że w miarę rozwoju AI rządy będą musiały wymyślić globalne ramy jej regulacji. W marcu tysiące ekspertów od sztucznej inteligencji, badaczy i jej zwolenników, w tym właściciel Twittera Elon Musk, podpisało list wzywający do wstrzymania tworzenia "gigantycznych" sztucznych inteligencji na co najmniej sześć miesięcy w związku z obawami, że rozwój technologii może wymknąć się spod kontroli.

Zapytany, czy uregulowania jakie dotyczą broni jądrowej mogłyby być potrzebne, Pichai powiedział: "Potrzebowalibyśmy tego".

Technologia AI użyta w ChatGPT i Bard, znana jako Large Language Model, jest szkolona na ogromnym zbiorze danych pobranych z internetu i na zadane przez użytkowników pytania jest w stanie wygenerować wiarygodne odpowiedzi w różnych formatach, od wierszy do esejów akademickich i kodów oprogramowania.

Dezinformacja może wyrządzić szkody

Pichai zauważył, że AI może wyrządzić szkody poprzez swoją zdolność do wytwarzania dezinformacji.

"Z AI będzie możliwe łatwo stworzyć wideo, w którym Scott (Pelley, prowadzący wywiad w CBS - PAP) mówi coś, albo ja mówię coś, czego nigdy nie powiedzieliśmy. I mogłoby to wyglądać realistycznie. Ale wiesz, na skalę społeczną może to spowodować wiele szkód" - wyjaśnił.

Zapewnił, że wersja sztucznej inteligencji upubliczniona przez Google'a poprzez chatbota Bard jest bezpieczna, a firma wstrzymała bardziej zaawansowane wersje Barda do testów.

Pichai przyznał, że Google nie do końca rozumie, jak jego technologia AI produkuje pewne odpowiedzi.

"Jest pewien aspekt tego, który nazywamy, wszyscy w tej dziedzinie nazywają, >>czarną skrzynką<<. Wiesz, nie rozumiesz w pełni. I nie możesz do końca powiedzieć, dlaczego ona powiedziała to, albo dlaczego się pomyliła" - mówił.

Zapytany, dlaczego Google upubliczniło Barda, skoro nie do końca rozumie jak działa, Pichai odpowiedział: "Pozwól mi to ująć w ten sposób. Nie sądzę, że my też w pełni rozumiemy, jak działa ludzki umysł".

Pichai przyznał, że społeczeństwo nie wydaje się być gotowe na szybkie postępy w AI. Powiedział, że "wydaje się, że istnieje niedopasowanie" między tempem, w jakim społeczeństwo myśli i dostosowuje się do zmian, w porównaniu z tempem, w jakim AI się rozwijała.

Dodał jednak, że przynajmniej ludzie szybciej stali się czujni na jej potencjalne zagrożenia.

"W porównaniu z każdą inną technologią, widziałem więcej ludzi zaniepokojonych nią na wcześniejszym etapie jej cyklu życia. Czuję się więc optymistycznie" - przekonywał.

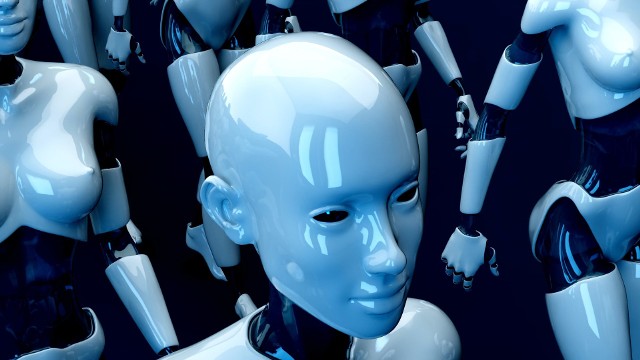

Filmy ostrzegają przed sztuczną inteligencją od lat

Motyw sztucznej inteligencji pojawia się w produkcjach filmowych od bardzo dawna, na długo nim weszła ona na poziom, jakiego doświadczamy dziś. Reżyserzy czy scenarzyści wątek wymknięcia się spod kontroli AI wykorzystywali bardzo często.

Mamy wiele klasyków światowego kina, który w różny sposób dotykają tego tematu, jak chociażby "Terminator" czy "Matrix", ale również współcześnie, gdy technologia jest dużo bardziej zaawansowana, twórcy filmowi lubią opierać się na tym wątku.

Dwie przykładowe propozycje ostatnich lat to chociażby film "Avengers: Czas Ultrona" czy serial "Westworld". W pierwszym z nich główny bohater stwarza program, który ma pomóc w dopilnowaniu pokoju na świecie, jednak ten wymyka się spod kontroli i zaczyna przejmować władzę nad światem i próbuje doprowadzić do zagłady ludzkości.

W serialu natomiast możemy obserwować jak w futurystycznym parku rozrywki tzw. hosty również przestają reagować na kontrolę obsługi parku i stają się coraz bardziej świadome, co prowadzi do licznych niebezpieczeństw.

dś

Źródło: